ניתוח כלכליסטרגולציה אירופית מהפכנית על AI תגביל מעקבים ותעמולה

ניתוח כלכליסט

רגולציה אירופית מהפכנית על AI תגביל מעקבים ותעמולה

הצעה לפיקוח על מערכות בינה מלאכותית שהגיש האיחוד האירופי ועשויה להביא לשינוי מהותי בתחום מתמקדת בזכויות הפרט ובמניעת שליטה מניפולטיבית בציבור. רעיונית היא ממוקמת בין גישת השוק החופשי בארה"ב לגישה הסמכותנית בסין

מסמך של הפרלמנט האירופי הנוגע לרגולציה בתחום הבינה המלאכותית, שדלף בשבוע שעבר ואתמול הוצג באופן רשמי, מעורר עניין רב: המסמך מציע דרך שלישית לרגולציה, או "גישה ממוקדת בני אדם", שמנסה לפשר בין גישת השוק החופשי האמריקאית לגישה הסמכותנית הסינית.

הגישה האירופית מתכוונת לרתום את הטכנולוגיה, אך לשמור במקביל על פרטיות האזרחים. על פי ניסיון העבר, מאמצי הרגולציה של האיחוד האירופי בנוגע למגזר הטכנולוגיה הופכים מאוחר יותר לאבן דרך בעולם כולו. "בינה מלאכותית יכולה להעניק יתרון תחרותי מהותי לחברות ולתמוך בתוצאות מועילות מבחינה חברתית וסביבתית", נכתב בטיוטת החקיקה, "יחד עם זאת, חלק מהיישומים עשויים לייצר סיכונים ולפגוע באינטרסים ובזכויות המוגנים על ידי חוק האיחוד".

עוד מציין המסמך, כי בינה מלאכותית יכולה לאפשר סוג חדש של שליטה מניפולטיבית, ממכרת וחברתית, כמו גם שיטות פיקוח חסרות הבחנה ומזיקות. אותן, נאמר שם, "יש לאסור, בהיותן מנוגדות לערכי האיחוד של כבוד האדם, חופש, דמוקרטיה ושלטון החוק".

טיפוח אמון במערכות

המסמך מנסה להתמודד עם מציאות מורכבת שבה מערכות של בינה מלאכותית ולמידת מכונה הפכו לחלק אינטגרלי מהחיים, באופן שבו בני אדם אינם תמיד מודעים לכך. מהלך זה הוא חלק ממגמה עולמית שבמסגרתה מנסות ממשלות לרסן את כוחן של חברות הטכנולוגיה על רקע החששות מפגיעה בפרטיות, שימוש במידע מוטעה או פגיעה בתחרותיות.

בהקשר זה, השלטונות בסין הטילו לאחרונה קנס בגובה 2.8 מיליארד דולר על עליבאבא, ארה"ב פתחה בחקירות נגד גוגל ופייסבוק, והודו אימצה כללים חדשים כדי לפקח על הרשתות החברתיות. "ככל שכוחן של הפלטפורמות הדיגיטליות גדל, כך הולך ומתבהר כי אנו זקוקים לכלים נוספים כדי לפקח על הכוח הזה", אמרה בחודש שעבר מרגרט וסטאגר, הנציבה לענייני תחרות באיחוד האירופי.

במקביל לרגולציה האירופית פרסמה נציבות הסחר הפדרלית בארה"ב (FTC) אזהרה לפיה כלי AI שמשקפים הטיות מגדריות וגזעיות עלולים להפר חוקי הגנת הצרכן. עוד ציינו, כי במידה וכלים מסוג זה מיושמים בתחומי הדיור או תעסוקה, או מוצגים שלא בצדק כבלתי משוחדים או נשענים על מערכי נתונים שנאספו באופן בעייתי, הנציבות עלולה להתערב.

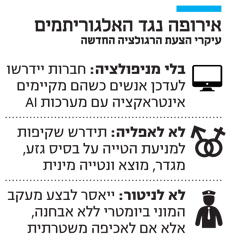

בבסיס המסמך האירופי עומד העיקרון המבקש לטפח אמון במערכות אלו, וזאת בעיקר באמצעות עיקרון אחר — שקיפות. כך למשל, חברות יידרשו לעדכן אנשים כי הם מקיימים אינטראקציה עם מערכות AI או עם תוכן שנוצר באמצעות מערכות אלה. דוגמה לכך היא תמונה שעברה מניפולציה או נוצרה באמצעות מערכות AI. שקיפות מסויימת תידרש גם במערכי הנתונים שמאמנים את מערכות הבינה המלאכותית, כדי להבטיח שהן אינן מוטות מבחינת סיווג כמו מגדר, גזע, גיל, נטייה מינית, דת או מוצא. בכך תיכחד גישת "הקופסה השחורה" שבה נוקטות כל החברות בתחום, ולפיה מערכי הנתונים שהמודלים מאומנים באמצעותם אינם נבחנים, ותהליך הלמידה וקבלת ההחלטות של האלגוריתמים אינו ברור.

לא כל הטכנולוגיות נולדו שוות, ולפיכך, באיחוד מבדלים בין טכנולוגיות מבוססות AI בסיכון נמוך שלהן לא יידרשו מנגנוני בקרה מחמירים — כמו אלו שנועדו לסייע במאבק האקלים או לייעול תשתיות — לעומת כאלה שיסווגו כבעלות "סיכון גבוה" ואחרות שיהיו אסורות לגמרי.

מערכות בסיכון גבוה הוגדרו ככאלה שיכולות להשית נזקי גוף או רכוש או לייצר השפעה שלילית חברתית או מערכתית. לקטגוריה זו נכנסות גם מערכות המסוגלות לייצר השפעות שליליות על הזדמנויות פיננסיות, חינוכיות או מקצועיות, כמו גם על גישה לשירותים ציבוריים וזכויות יסוד אחרות. מערכות מסוג זה קיימות כבר היום וקשורות, למשל, למתן אשראי, גיוס עובדים ומניעת פשעים.

כדי שיוכלו להיות בשימוש באיחוד האירופי, החברות שמפעילות אותן יצטרכו לציית לכללי שקיפות מחמירים ולכללים הנוגעים לפיקוח אנושי על מערכי הנתונים שנדרשים לאמן את המערכות. אלה שימשיכו, תוך כדי הפעלתן, לאסוף נתונים וללמוד אותם ייאלצו לעבור הערכות תאימות תקופתיות.

בנוסף, בכוונת אירופה להציג שורה של איסורים גורפים. כך למשל ייאסר השימוש במערכות אם הן משמשות לשינוי התנהגות או החלטות של אנשים, או כדי לגרום להם לגבש דעה באופן מניפולטיבי. כן ייאסר להפעילן אם הן מנצלות חולשות אנושיות. במקביל ייאסר לבצע מעקב המוני ביומטרי ללא הבחנה, בין אם באמצעות מצלמות או ניטור מיקום וחום גוף, אלא אם ניתן אישור מראש למטרות אכיפה משטרתית. איסור יחול גם על הפעלת מערכות מסוג זה שנועדו לסווג אנשים באמצעות נתונים חסרי הקשר. חברות שיפרו את הכללים מסתכנות בקנס של עד 20 מיליון יורו או 4% ממחזור ההכנסות העולמי שלהן.

3 צפייה בגלריה

נציבת התחרותיות של האיחוד האירופי, מרגרט וסטאגר. "אנו זקוקים לכלים נוספים כדי לפקח על הכוח הזה"

(צילום: איי פי)

בפועל, העקרונות הללו הופכים שורה של פרקטיקות מקובלות מאוד, אם כי מעוררות מחלוקת, לאסורות. המשמעות היא, שמוסדות פיננסיים לא יוכלו להשתמש במוצרים מבוססי AI שמסייעים להם לדרג צרכנים, אם הם למשל משתמשים במידע כמו מוצא או שכונת מגורים כדי לשפוט את יכולות החזר החוב. מרכזים מסחריים לא יוכלו יותר לעקוב אחרי הנכנסים והיוצאים באמצעות כלים שנועדו לאתר ולחזות אנשים ש"מועדים למעשים פליליים". ואולי מהותי יותר, הצעת ההסדרה האירופית למעשה מסכלת את השימוש הפוליטי הנרחב במודעות פוליטיות ממוקדות. עם זאת, קשה לקבוע כי לשון התקנות אוסר פרסום ממוקד גורף, שכן ניתן יהיה לטעון שאין בפרסום כזה השפעה מזיקה על המשתמשים.

ההסדרה צפויה לחול על כל מוצר שנבנה בגבולות האיחוד, מופעל על שוק האיחוד (בין אם החברה עצמה מפעילה אותו באיחוד או ממדינה שלישית) או משפיע על תושביו. עם זאת, הכללים אינם חלים על שימושים צבאיים.

רגולציה מנופחת וחונקת

ההסדרה האירופית אינה חפה מבעיות. היא מתנגשת עם מאמצי היבשת להתחרות עם ארה"ב וסין בתחום, כפי שמשתקף בהודעת האיחוד כי ישקיע 3 מיליארד יורו בחברות סטארט־אפ בתחום. ברמה המעשית, הרגולציה מורכבת והמגזר עצום. נציבות האיחוד עצמה הודתה לא אחת, כי גם תקנות הגנת הנתונים (GDPR) אינן מיושמות בעקביות, ואפשר להניח שרגולציה על AI תיתקל באותן בעיות, אם לא יותר. הצעת ההסדרה מותירה את האכיפה בידי המדינות החברות שיצטרכו להתמודד עם מערכת אקולוגית חדשה ומורכבת במיוחד של פיקוח, שכוללת עמידה בכללים ורישום המערכות לפי סיווג הסיכון.

בעיות אלו, כמו גם עצם ההסדרה, גררו ביקורת. בין היתר נטען כי הרגולציה מנופחת, כי היא צפויה לחנוק חדשנות, לגרום לאירופה לפגר (עוד יותר) אחרי סין וארה"ב במרוץ הטכנולוגי ולהביא לאובדן מקומות עבודה והשקעות. עם זאת, לאיחוד האירופי יש דווקא ניסיון טוב בנושא. בפעם האחרונה שבה פעל להסדיר את מגזר הטכנולוגיה הוא זכה להצלחה, שהובילה לגל חיקוי בעולם: ה־GDPR שנכנסו לתוקף ב־2018 אומצו בחום ועודדו שיח בנושא. ב־2020 קליפורניה עצמה אימצה כללים דומים. באיחוד האירופי, כך מסתבר, אולי אין ענקיות טכנולוגיה כפי שיש לסין או ארה"ב, אך יש ענקית רגולטורית דומיננטית ורלוונטית שממצבת אותו כשחקן בינלאומי מוביל.