למקסם רווחים בלי לאבד את האמון: למה מודלי שפה חייבים להיות הוגנים

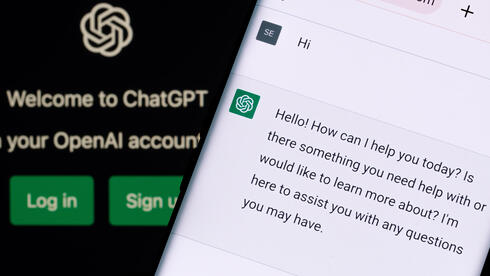

הבינה המלאכותית הפכה כבר מזמן מניסוי במעבדות של חוקרים לטכנולוגיה לכלי טכנולוגי שנמצא בלב אינספור מוצרים שמשפיעים על חיינו. צ'אטבוטים מנהלים שיחות עם לקוחות, מערכות אוטומטיות מקבלות החלטות פיננסיות, ומודלים חכמים מנתחים קורות חיים כדי לסנן מועמדים למשרות. אבל עם כל ההתקדמות המרשימה, נשאלת השאלה—עד כמה אנחנו באמת יכולים לסמוך על ההחלטות שהמערכות האלו מקבלות? ואם הן לא תמיד הוגנות—עד כמה זה עלול לפגוע בחברות שמשתמשות בהן?

קחו למשל מערכת בינה מלאכותית שפותחה כדי לעזור לחברות לזהות מועמדים מתאימים לתפקידים טכנולוגיים. בתחילת הדרך, היא נראתה כמו הצלחה מסחררת—היא זיהתה תבניות יעילות והמליצה רק על המועמדים שהכי התאימו לתפקיד. אבל אחרי כמה חודשים התברר משהו מטריד: כמעט כל ההמלצות שלה היו לגברים. למה? כי המודל אומן על נתונים היסטוריים של מועמדים מוצלחים, ובתעשייה שבה במשך עשורים גברים היו הרוב המוחלט, האלגוריתם פשוט שיחזר את הדפוסים האלו בלי להבין שהוא מנציח את האפליה.

האתגר המרכזי של מודלי שפה גדולים, בשפה המקצועית LLMs, הוא ההטיה המובנית שלהם. כשמודל מאומן על כמויות עצומות של נתונים, הוא סופג מתוכן הדאטה גם את הדעות הקדומות שמוטמעות בו. לפעמים זה דק ובלתי נראה, ולפעמים זה מובהק ומסוכן. כשמודל כזה הופך להיות מנוע של החלטות עסקיות, ההשפעה של הטיות יכולה להיות הרסנית—גם מבחינה חברתית וגם כלכלית. אם מודל גיוס מזהה דפוסים שמעדיפים מועמדים מקבוצה מסוימת על פני קבוצה אחרת, הוא עלול להנציח אפליה במקום לנטרל אותה. אם מערכת להערכת סיכוני אשראי מושפעת מהיסטוריית נתונים לא מאוזנת, היא עלולה לפסול בקשות אשראי באופן לא הוגן. כשהדברים האלו קורים, הנזק לא מסתכם רק באי-צדק כלפי המשתמשים—חברות שמשתמשות במודלים האלה מסתכנות בפגיעה במוניטין, איבוד לקוחות, ואפילו תביעות משפטיות.

הסכנה הגדולה ביותר היא שחברות רבות עדיין מתייחסות להטיות כאל בעיה אתית או תאורטית, מבלי להבין את ההשלכות הכלכליות של ההטיות הללו: מערכת שממליצה ללקוח את מוצר לא רלוונטי מפסידה פעמיים: גם רווח פוטנציאלי של מוצר שהיתה יכולה למכור בהצלחה, וגם חווית לקוח פגומה. ברגע שהלקוחות מבינים שהאלגוריתם לא הוגן, האמון נשבר—ואמון הוא אחד המשאבים הכי יקרים בשוק תחרותי.

יש מי שיטענו שאין דרך אמיתית לנקות לחלוטין את ההטיות ממודלי שפה, וזה נכון במידה מסוימת. מודל שמבוסס על נתונים לעולם יהיה תוצאה של אותם נתונים. אבל יש הבדל בין מודל שמכיל שאריות של הטיה בלתי נמנעת לבין מודל שלא עבר שום התאמה כדי למנוע תוצאות בעייתיות. חברות שמשקיעות במדידה שקופה של הוגנות, שמתאימות את המודל לשוק היעד, ושמבינות שהדיוק של המודל לא יכול לבוא על חשבון ההוגנות—הן החברות שיצליחו למקסם רווחים בלי לאבד את אמון הלקוחות.

בשנים האחרונות פורסמו מקרים שבהם מודלים של בינה מלאכותית קיבלו החלטות שגויות שגרמו להפסדים כספיים כבדים ולסערות ציבוריות. חברות שציפו שהטכנולוגיה תעשה עבורן את העבודה גילו שללא פיקוח ובקרה הדוקים, הן עלולות להיכשל בענק. כשמודל מקבל החלטות לא הוגנות, הבעיה אינה במחשבים ש"לא עובדים נכון", אלא בעסקים שלא הקדישו מספיק מחשבה לאופן שבו הבינה המלאכותית משתלבת במודל העסקי שלהם.

בטווח הארוך, חברות שלא ישקיעו בבקרה ותיקון מתמיד של מודלי ה-AI שלהן יישארו מאחור. ההחלטה להשקיע בהוגנות של המודל, אם כן, אינה רק סוגיה אתית אלא גם החלטה עסקית.

אביב בן אריה היא מנהלת Data Science במרכז הפיתוח של Intuit בישראל