מדענים מובילים בתחום ה-AI מזהירים: "אנחנו עלולים לאבד שליטה על המערכות"

25 מדעני בינה מלאכותית, בהם בכיר מובילאיי פרופ' שי שלו-שוורץ מהאוניברסיטה העברית, סבורים כי יש להטמיע באופן מיידי מנגנוני פיקוח ובקרה בפיתוח מערכות בתחום; לדבריהם, "AI יכולה לסייע לאנושות לרפא מחלות ולשפר את רמת החיים, אבל גם להעצים אי-צדק חברתי, לשחוק את היציבות החברתית ולאפשר פשיעה בקנה מידה גדול"

על ממשלות, חוקרים וחברות להטמיע באופן מיידי מנגנונים והליכי פיקוח, בקרה והגנה בפיתוח מערכות בינה מלאכותית (AI), או להסתכן בנזקים נרחבים משמעותיים, שיכולים לכלול גם את הכחדת המין האנושי – כך מתריעים 25 ממדעני ה-AI המובילים בעולם במאמר דעה שפרסמו אתמול בכתב העת המדעי היוקרתי Science.

לדבריהם, "ללא זהירות מספקת, אנחנו עלולים לאבד כל שליטה על מערכות AI אוטונומיות. אנחנו לא במסלול הנכון להתמודדות עם סיכונים אלו, וכבר נמצאים בפיגור".

מהפכת הבינה המלאכותית, ובפרט הבינה המלאכותית הגנרטיבית (GenAI) הציתה את הדמיון האנושי מאז חשפה OpenAI את Dall-E ואת ChatGPT ב-2022, וכבר החלה לשבש פעילויות של תעשיות שונות. מאז נחשף ChatGPT לפני כשנה וחצי, בכמה הזדמנויות שונות התריעו מדענים ובכירים בתעשייה מפני הסכנות האפשריות שלה.

המאמר הנוכחי מצטרף לאזהרות אלו, וזוכה לחשיבות מיוחדת הן לאור מקום פרסמו - כתב העת המדעי החשוב בעולם בתחום המדעים המדויקים - הן לאור הפריסה הרחבה של הצעדים שיש לנקוט, והן לאור זהות כותביו שכוללים את המדענים המובילים ביותר בתחום, ובהם פרופ' ג'פרי הינטון מאוניברסיטת טורנטו (שמכונה "הסנדק של AI"), חתן פרס טיורינג פרופ' יהושע בנג'יו מאוניברסיטת מונטריאל, פרופ' אנדרו יאו מאוניברסיטת צ'ינגחווה, ובכיר מובילאיי פרופ' שי שלו-שוורץ מהאוניברסיטה העברית.

לדברי המדענים, אף שמערכות AI קיימות עדיין נעדרות יכולות מרכזיות שלא ברור כמה זמן יידרש על מנת לפתחן, חברות שונות פעולות על מנת ליצור מערכת בינה מלאכותית כללית (AGI), שהיא בעלת יכולות קוגניטיביות זהות או טובות יותר משל בני אדם. "אין שום סיבה שהתקדמות ה-AI תאט או תעצר ברמת היכולות האנושיות", הם טוענים. "AI כבר טובה יותר מבני אדם בתחומים כמו משחקים אסטרטגיים וחיזוי קיפול חלבונים. בהשוואה לבני אדם, מערכות AI פועלות מהר יותר, סופגות יותר ידע ומתקשרות ברוחב פס גדול יותר.

"אנחנו חייבים לקחת ברצינות את האפשריות שמערכות AGI עוצמתיות ביותר ובעלות יכולות טובות מאשר בני אדם במגוון תחומים יפותחו בעשור הקרוב או בזה שאחריו. מה יקרה אז? אם תנוהל בזהירות ותוטמע בהגינות, AI תוכל לסייע לאנושות לרפא מחלות, לשפר את רמת החיים, ולהגן על מערכות אקולוגיות. ההזדמנויות עצומות.

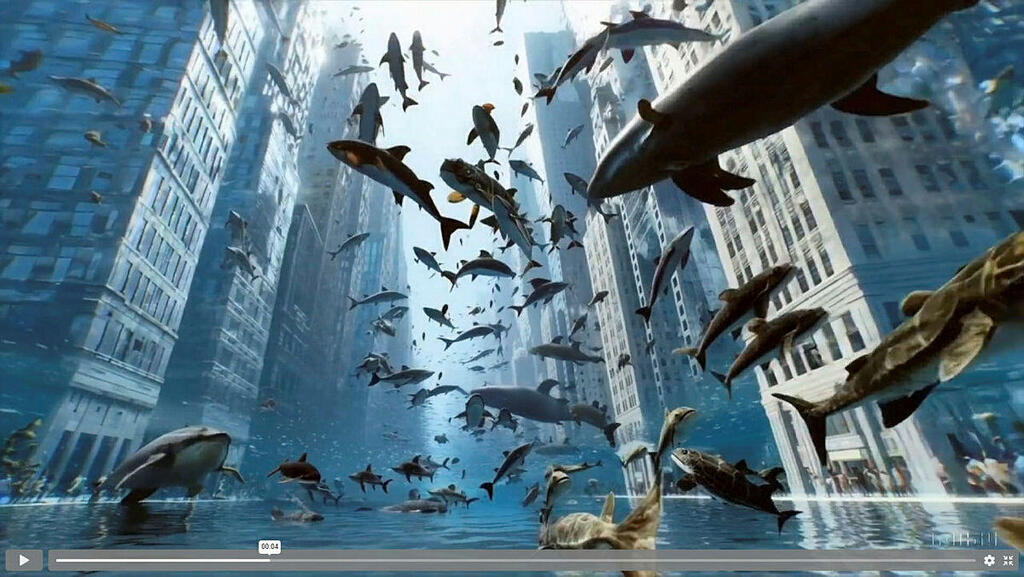

"אבל יכולות שכאלו מגיעות עם סיכונים בקנה מידה גדול. מערכות AI עלולות להעצים אי-צדק חברתי, לשחוק את היציבות החברתית, לאפשר פשיעה בקנה מידה גדולה, ולסייע למניפולציית המונים ולמעקב פולשני. פיתוח AI אוטונומית יכול לייצר גם סיכונים חדשים אם לא תהיה אפשרות להגביל את פעילות המערכות.

"ללא זהירות מספקת, אנחנו עלולים לאבד באופן בלתי הפיך את השליטה על מערכות AI אוטונומיות, וכל התערבות אנושית תהיה בלתי יעילה. פשיעת סייבר בקנה מידה גדול, מניפולציה חברתית ונזקים אחרים יכולים לצבור תאוצה במהירות. התוצאה הסופית יכולה להיות אובדן חיים וביוספרות בקנה מידה גדול, ודחיקה לשוליים או הכחדה של המין האנושי".

המדענים מזהירים גם שבשעה שמשאבים אדירים מוכוונים לפיתוח מערכות AI, רק מיעוט מהם מיועד לפיתוח פתרונות הגנה ומיתון נזקים. "אנחנו חייבים לחשב כיוון מחדש", הם כתבו. "העלות של לא להיות מוכנים גבוהה הרבה יותר מזו של מוכנות יתר".

על מנת לאפשר מוכנות כזו, מציעים המדענים שורת צעדים, ובהם מיקוד מאמצי מו"פ בפריצות דרך ליצירת AI בטוחה. אלו כוללים יצירת מגנוני פיקוח, חסימות, הדדיות ושקיפות, לצד הקמת צוותי פיתוח מגוונים ופיתוח מענה לאתגרים חדשים. כמו כן נדרשים הערכה יסודית של יכולות מסוכנות, שכיום מתגלות פעמים רבות רק אחרי הפעלתן, ופיתוח כלים שיאפשרו לזהות איומי AI דוגמת קמפייני השפעה, סיכונים ביולוגיים ומתקפות סייבר - ולהתגונן מפניהם.

ממשלות נדרשות גם הן לשורה של מהלכי פיקוח ורגולציה, על מנת לקבוע ולאכוף תקנים שימנעו התנהגות חסרת אחריות או שימוש לרעה. "בתחומי טכנולוגיה רבים כבר ברור שיש צורך בפיקוח ממשלתי יעיל כדי להפחית סיכונים", נכתב. "עם זאת, המסגרות הרגולטוריות ל-AI מפגרות הרבה אחרי ההתקדמות הטכנולוגית. גם התוכניות הקיימות מפגרות באופן קריטי אחרי ההתקדמות המהירה ביכולות AI".

המדענים מסכמים: "כדי לכוון את הבינה המלאכותית לכיוון חיובי והרחק מקטסטרופה, אנחנו צריכים לבצע כיוונון מחדש. יש נתיב אחראי, אם תהיה לנו את החוכמה לצעוד בו".